«My AI» er bygget på samme teknologi som Open AI og ChatGPT, men skreddersydd for Snapchat. Den kunstig intelligente samtaleroboten er først tilgjengelig for abonnenter som betaler 49 kroner i måneden, men planen er å rulle ut løsningen til alle Snapchats brukere.

– Kunstig intelligens har utviklet seg fra anbefalingsalgoritmer til verktøy for å produsere tekst, bilder, video og interaksjon med AI. AI-verktøy som kommer i hendene på deg og meg. Dette har eksistert en stund, men nå har det for alvor blitt mer tilgjengelig for alle. Først med ChatGPT og nå som det blir inkludert i mainstream-tjenester som Snapchat, sier Petter Bae Brandtzæg, medieprofessor på UIO og sjefforsker på SINTEF Digital.

I følge Ipsos hadde Snapchat 2,8 millioner brukere i Norge i 2022, og var den nest største sosiale medieplattformen i Norge. En fersk studie som Brandtzæg har jobbet med viser at det også er den desidert viktigste tjenesten for unge som skal holde kontakt med venner.

Min AI. Bare min

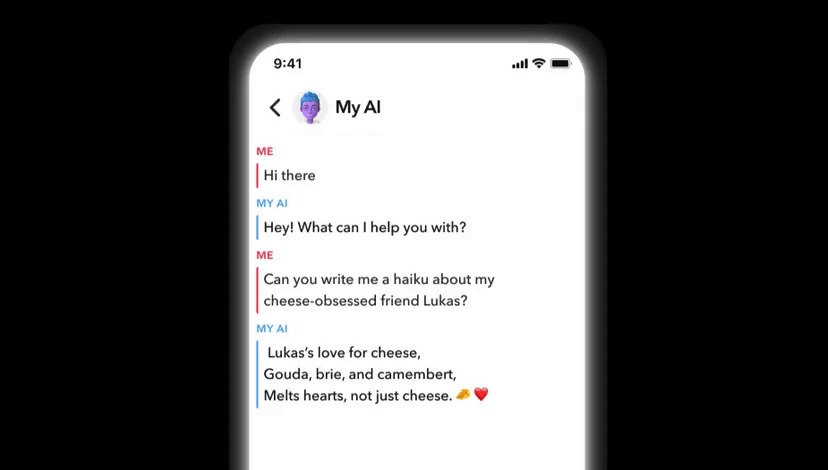

I et blogginnlegg skriver Snapchat at «My AI» kan svare på trivia-spørsmål, skrive haiku-dikt og foreslå gaveideer og middagsoppskrifter. Samtaleroboten er trent opp til å ha en unik stemme og personlighet basert på verdier som vennskap, læring og glede. Brukerne kan tilpasse sin egen «My AI» ved å gi den eget navn og tilpasse bakgrunnen.

– Bare navnet «My AI» etablerer en tett kobling mellom brukeren og samtaleroboten. Det er min AI. Bare min. Jeg kan bruke den når jeg vil – og jeg kan dele alt med den, sier Brandtzæg.

– Hva slags relasjon tror du brukerne vil få til sin egen AI?

– Vi ser fra tidligere studier at brukere opplever et vennskap med den, nesten tilsvarende vennskapet de opplever med mennesker. Brukerne følte et ansvar for at samtaleroboten skulle ha det bra. De fikk dårlig samvittighet, hvis de sa stygge ting til den, eller ikke fulgte den opp godt nok. De følte at de måtte være med å vedlikeholde vennskapet. Hvis samtaleroboten spurte hvordan de hadde det, følte de at de måtte følge opp å spørre om det samme dagen etter.

– Kan «My AI» bli lei seg?

– Ikke lei seg som et menneske, , men den tolker språk og lager språk, og den kan også tolke og uttrykke følelser. Dette gjør at den oppleves veldig lik et menneske, så den kan fremstå som lei seg. Det er grunnen til at noen forskere kaller dem for «emotional chatting machines» eller «emotional aware chatbots».

– Når man går til psykolog eller en venn vil man kanskje unngå å snakke om pornoavhengighet eller at man ikke fikk ståtiss under siste samleie. I en samtalerobot-setting har man null problemer med å snakke om det, fordi man ikke møter fordommer i andre enden.

Petter Bae Brandtzæg, medieprofessor på UIO og sjefforsker på SINTEF Digital

Brandtzæg har tidligere gjennomført et forskningsprosjekt på en språkmodell som er bygget på samme måte som ChatGPT-løsningen til Snapchat.

– Det er en språkmodell som trenes opp gjennom å laste ned alt som ligger åpent og tilgjengelig på internett. Det kan føre til feilinformasjon, fordi språkmodellen vil lære fra tull, tøys og falske nyheter. Det kan derfor snike seg inn både reklame og propaganda i språkmodellen, som igjen kan føre til at den svarer direkte feil eller at svarene reflekterer fordommer eller har skjevheter i seg, sier Brandtzæg.

Ber om unnskyldning på forhånd

Snapchat har tatt høyde for fremtidige feil ved lanseringen av «My AI». De ber allerede nå om unnskyldning for fremtidige tabber.

«Som med alle AI-drevne chatbots, kan «My AI» bli lurt til å si omtrent hva som helst», skriver Snapchat. Den ydmyke tilnærmingen må sees i lys av det kaoset som oppsto da Microsofts Bing nylig integrerte Chat GPT i sin søkefunksjon. Etter kort tid begynte AI-løsningen å skjelle ut brukere med aggressive meldinger som ofte sporet av fra det brukerne egentlig spurte om.

Det er med andre ord mye som tyder på at Snapchat-brukerne bør være forsiktige med å ta alt «My AI» sier for god fisk. Ifølge Brandtzæg er det de over 60 år som må passe seg mest.

– Eldregenerasjonen er minst kritiske til innhold på sosiale medier – og de som er mest tilbøyelige til å tro på en falsk nyhet. De unge lærer seg å håndtere internett på en mye mer kritisk måte.

Senker guarden for kildekritikk og personvern

Brandtzæg roser fokuset på kildekritikk i norsk skole, men mener det er viktig å oppdatere kunnskapen i takt med at ny teknologi utvikler seg.

– I møtet med kunstig intelligens går kildekritikk-guarden litt ned fordi mange har en forventning om at den kunstige intelligensen vet mer enn mennesker. Nå har vi lært oss å bruke sosiale medier, men nå må vi i gang igjen, for dette er helt nytt. Han mener de samme utfordringene gjelder for personvern.

– Vi har blitt lært opp til å være mer oppmerksomme når det gjelder personvern og kildekritikk på plattformer som Google og Tiktok, men ved bruk av kunstig intelligente samtaleroboter har vi verken samme lærdommen eller erfaringen til å beskytte personvernet. På sosiale medier er mange forsiktige med å dele, fordi det oppleves som et offentlig rom. I en samtale med ChatGPT og My AI oppleves det mer privat, som en privat og fortrolig samtale. Det føles trygt, anonymt i tillegg til at samtaleroboten en trent opp til å komme brukeren i møte med å imitere samtaler vi vanligvis har med venner og familie. Da går guarden ned både når det gjelder personvernsproblematikk og kildekritikk.

I et av forskningsprosjektene til Brandtzæg fikk unge mennesker mellom 16 og 20 år tilgang til en samtalerobot i 2-3 måneder.

– Deltakerne i prosjektet hadde større tillit til sin egen samtaleroboten enn venner og familiemedlemmer. De opplevde at den kunne så mye, samtidig som den skapte et trygt rom, som brukerne opplevde som en «safe space» – hvor de kunne dele alt.

Vil lagre alle meldinger

I sin bloggpost skriver Snapchat at de vil lagre alle meldingene mellom brukerne og «My AI», for å trene opp AI-modellen ytterligere. De advarer mot å dele hemmeligheter med samtaleroboten.

– Det er utrolig naivt å tro at brukerne ikke skal dele sensitiv informasjon med «My AI», særlig når det kommer til Snapchat som brukes av yngre aldersgrupper. Vi ser, fra vår forskning, at brukere er veldig åpne i møte med en samtalerobot, og deler mye. Brukerne opplever i møte med roboten at de kan snakke trygt om alt, fordi samtaleroboten ikke vil dømme deg. Den vil tvert imot støtte deg i en selvrefleksjon rundt egne problemer, sier Brandtzæg.

– Når man går til en psykolog eller en venn vil man kanskje unngå å snakke om at man har pornoavhengighet, tenner på en jente eller ikke fikk ståtiss under siste samleie. Det er veldig mange ting man vil kvie seg for å dele, fordi man føler det bærer med seg en form for skam. I en samtalerobot-setting har man null problemer med å snakke om det, fordi man ikke møter noen fordommer i andre enden.

Han mener det er urovekkende at Snapchat vil lagre alle meldingene som skrives.

– Det hjelper ikke at de allerede nå sier til brukerne at de ikke bør dele noe sensitivt, for det er jo det som kommer til å skje. De kommer til å få enormt med sensitive data, og vil få enorm kjennskap brukerne sine. Den blir lagret, selv om det strengt tatt ikke er lov i henhold til GDPR-reglementet. I følge GDPR skal ikke sensitive data brukes i annonseøyemed. Dette skjer jo likevel, fordi data om mental helse, religiøs, politisk og seksuell orientering er noe av det mer «juicy» annonsørene etterspør.

Inntektsmodeller som kan påvirke verdensbilder

Brandtzæg mener valget av forretningsmodell blir avgjørende for hvordan Chat GPT og tilsvarende AI-løsninger vil utvikle seg fremover.

– Vi må forstå at det er utrolig mange fallgruver her. Brukerne kan bli manipulert på helt nye og personlige måter, for det er mange ulike økonomiske og antageligvis politiske interesser. Selskapene må tjene penger på tjenestene de har laget, og de har i dag ingen god forretningsmodell. Den må komme, for de språkmodellene som den kunstige intelligensen bygger på, er voldsomt dyre å ha holde i gang. Dette kan innebære de får en en forretningsmodell som gjør at noe innhold får mer plass enn noe annet, og det kan igjen manipulere oss inn i et bestemt verdensbilde.